Google, yapay zeka tarafından oluşturulan içeriği doğrulamak için SynthID'yi tanıttı

Görüntülerde, videolarda, seslerde ve yazılı içerikte yapay zeka tarafından üretilenler ile gerçek olanı ayırt etme ve tanıma yeteneği giderek daha önemli hale geliyor. Birden fazla türde dijital içerik üretebilen gelişmiş dil modellerinin tanımlanması giderek zorlaşıyor. Google, dijital içeriğin doğruluğunu ve güvenliğini artırmayı amaçlayan SynthID'nin beta testini duyurdu.

SynthID filigranlama sistemi nasıl çalışıyor?

Basitçe söylemek gerekirse, büyük bir dil modeli (LLM) bir kullanıcıdan gelen bir sorguya veya isteğe yanıt verdiğinde, model, isteği karşılamak için "en iyi sonucun" ne olduğunu tahmin eder.

Model yanıt karakterini üretirken, SynthID aracı modelin seçebileceği her potansiyel kelimeye anında görünmez bir olasılık değeri atar. Örneğin, modelden "Bir evcil hayvanım var ___" cümlesini tamamlamasını isteseydiniz, "köpek" kelimesi muhtemelen 0,9 gibi yüksek bir olasılık değerine sahip olurken, "gila kertenkelesi" 0,01 civarında çok daha düşük bir değere sahip olurdu. Bu tahmine dayalı süreç, orijinal sorgu gereksinimleri karşılanıncaya kadar devam eder.

"Modelden elde edilen kelime seçimi puanlarının son şekli, uygun olasılık değerleriyle birleştiğinde filigranı oluşturur. Bu teknik en az üç cümlede kullanılabilir. Metnin uzunluğu arttıkça SynthID'nin doğruluğu ve sağlamlığı da artıyor.

Şirket ayrıca bu teknolojinin artık geliştiricilerin kendi yapay zeka üretken dil modellerine entegre edebilmeleri için ücretsiz olarak sunulduğunu da belirtti. Google, "Ayrıca, daha güvenli yapay zeka uygulamaları oluşturmaya yönelik temel rehberlik ve araçları sağlayan Google Sorumlu Üretken Yapay Zeka Araç Seti aracılığıyla açık kaynak olarak da yayınladık. Geliştiricilerin bu teknolojiyle çalışıp entegre edebilmesi için teknolojiyi kendi platformlarında kullanılabilir hale getirmek üzere Hugging Face ile iş birliği yaptık" dedi.

SynthID gibi araçlara duyulan ihtiyaç

MIT FutureTech'te yapay zeka riskleri alanında önde gelen bir araştırmacı olan Ph.D. Peter Slattery, bu teknolojinin e-posta alışverişindeki kritik önemini vurguladı." Çevrimiçi bilgilerin bütünlüğünü korumak ve iletişim ekosistemimizi korumak için SynthID gibi teknolojilere acilen ihtiyacımız var. MIT AI risk deposundan ve olay izleyicilerinden, AI tarafından oluşturulan içeriğin "yanlış bilgi ve derin sahtekarlık" amacıyla kötüye kullanımının geniş çapta belgelendiğini ve giderek yaygınlaştığını biliyoruz. Dolayısıyla bu teknoloji önemli bir azaltım önlemi gibi görünüyor" dedi.

Ancak Slattery, en az bir çalışmanın, araştırmacıların SynthID'ye benzer bir dijital filigran modelini manipüle etmeyi veya çalmayı başardığını gösterdiğini belirtti . "Filigranların tahrifata karşı dayanıklı olduğundan ve bunların sahte olabileceği senaryolar yaratmadığımızdan emin olmak için çok dikkatli olmamız gerektiğini düşünüyorum. Filigranları sahteleştirme yeteneği, durumu iyileştirmek yerine daha da kötüleştirebilir" diye açıkladı.

Nature tarafından yayınlanan çalışmada Google araştırmacıları, SynthID'nin güçlü tespit yeteneklerine rağmen bunun tam bir çözüm olmadığını kabul etti. Araştırmacılar, "Üretken filigranların bir diğer sınırlaması, devam eden bir araştırma alanı olan sahtecilik, kimlik sahtekarlığı ve silme saldırılarına karşı savunmasızlıkları olarak belirtilebilir. Özellikle, üretken filigranlar, metin modelleri aracılığıyla başka sözcüklerle ifade etme gibi metinde yapılan düzenlemelerle zayıflatılır. Genellikle içeriği önemli ölçüde değiştirir" dedi.

"Yapay Zeka" Kategorisinden Daha Fazla İçerik

Yazarlar

Çok Okunanlar

-

forbes.com.tr

Dünyanın en zengin 10 insanı (Ocak 2025)

-

-

forbes.com.tr

En zengin Türklerin sıralaması nasıl değişti?

-

Nilgün Balcı Çavdar, Cem Cemal Pekin, Erkan Kızılocak

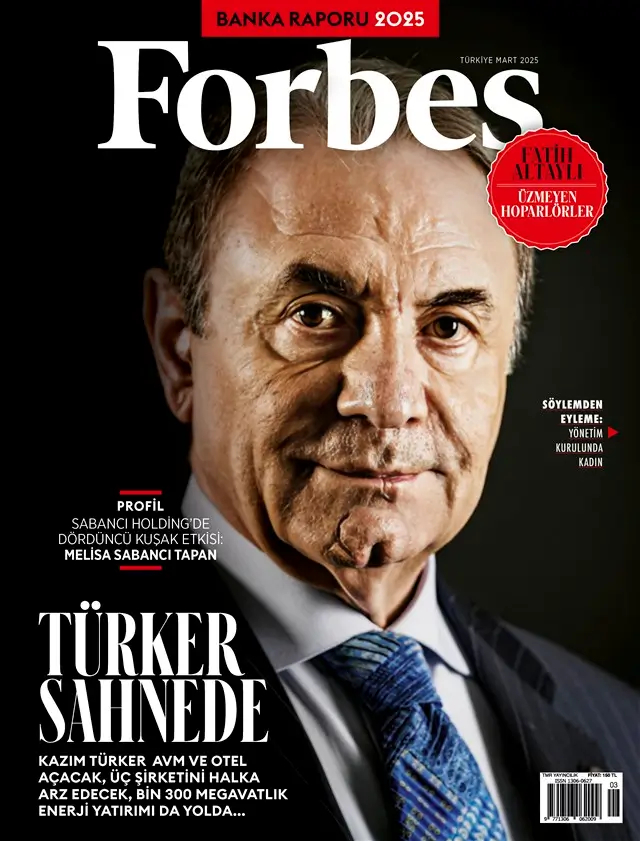

Forbes Türkiye dolar milyarderi Türkler 2025 listesi

-